deepseek 模型 V3 和 R1 的区别: 深度求索(DeepSeek)这家公司可谓是一举成名,迅速在人工智能领域引起了广泛关注。不过,我在访问官网时发现,在 DeepSeek 的官网上……

哈喽!伙伴们,我是小智,你们的AI向导。欢迎来到每日的AI学习时间。今天,我们将一起深入AI的奇妙世界,探索“deepseek 模型 V3 和 R1 的区别”,并学会本篇文章中所讲的全部知识点。还是那句话“不必远征未知,只需唤醒你的潜能!”跟着小智的步伐,我们终将学有所成,学以致用,并发现自身的更多可能性。话不多说,现在就让我们开始这场激发潜能的AI学习之旅吧。

deepseek 模型 V3 和 R1 的区别:

深度求索(DeepSeek)这家公司可谓是一举成名,迅速在人工智能领域引起了广泛关注。不过,我在访问官网时发现,在 DeepSeek 的官网上,展示的模型是 V3:

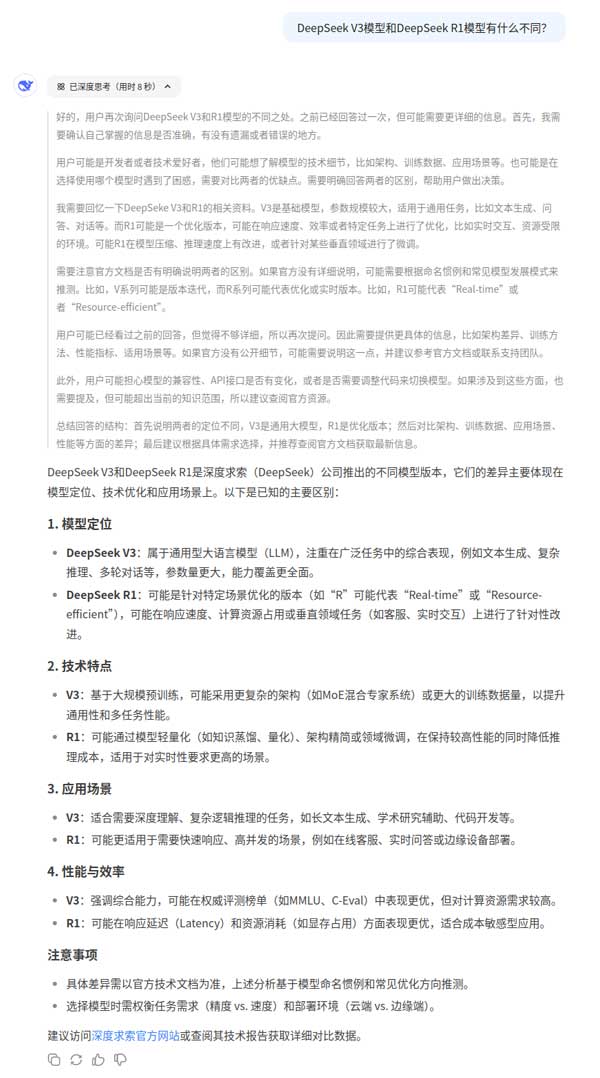

然而,真正让 DeepSeek 声名大噪的,却是 R1 这一模型。根据发布记录,V3 要早于 R1 发布。R1 开源发布,难道是 V3 的精简版本?就像很多商业软件的做法。就这个问题,我问了一问 DeepSeek,得到如下答案:

后面一个答案是开启了深度思考模式下的答案。这种深度思考模式也是 DeepSeek 引起轰动的原因之一,它会将分析过程展现出来,而不像之前的 GPT,就如同一个黑盒,只给出一个答案。

那么,DeepSeek V3 和 R1 之间到底有什么区别?为此,我专门去搜了一下资料,进行了总结。由于水平有限,不一定正确,如有错漏,还望指正。

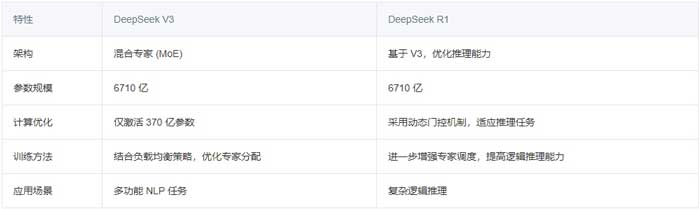

模型目标与设计理念

1.DeepSeek R1:专注于高级推理任务

DeepSeek R1 主要针对需要复杂逻辑推理的任务进行优化,并利用强化学习技术来提升推理能力。该模型特别适用于涉及逻辑推理和问题求解的应用场景。

2. DeepSeek V3:通用的自然语言处理模型

DeepSeek V3 采用混合专家(MoE)架构,主要面向自然语言处理(NLP)任务,旨在提供高效、可扩展的解决方案。其广泛的应用涵盖了客户服务、文本摘要、内容生成等多个领域。

模型架构解析

1.DeepSeek V3:混合专家(MoE)架构

DeepSeek V3 采用混合专家(Mixture-of-Experts, MoE)架构,这一设计极大地提升了大型语言模型的计算效率和性能。其关键特点如下:

• 选择性激活专家:

DeepSeek V3 共有 6710 亿 个参数,但在推理时,每次仅激活其中 370 亿 个参数。这样可以大幅降低计算成本,同时保证推理质量。

• 多头潜在注意力(MLA):

通过对注意力键值进行压缩,减少内存占用,提高推理效率,而不会损害注意力机制的质量。

• 智能路由系统:

该模型拥有一个复杂的路由机制,可根据任务类型自动激活最适合的专家。例如:

1.若输入是技术编码相关问题,模型会激活专精于编程语言的专家;

2.若输入是内容摘要请求,则会启用自然语言处理专家;

3.其他专家保持休眠,以节省计算资源。

• 动态负载均衡:

传统 MoE 模型通常依赖辅助损失来平衡负载,而 DeepSeek V3 采用动态偏差调整策略,确保不同专家的计算资源利用均衡,提高可扩展性和稳定性。

• 多令牌预测(MTP):

该机制允许模型在单次推理过程中预测多个词元(token),增强训练信号,提高在复杂任务上的表现。

2. DeepSeek R1 利用 V3 的架构优化推理

DeepSeek R1 充分利用了 V3 的架构,但在设计上针对推理任务进行了优化:

DeepSeek R1 依靠动态门控机制,使其在推理任务中表现出色。它可以根据查询内容选择性激活相关专家,从而在保证计算效率的同时,提供精准的逻辑推理能力。此外,该模型结合了负载均衡策略,确保专家间的合理分工,避免单个专家成为计算瓶颈。

DeepSeek V3 和 R1 各自擅长不同的任务领域:

• DeepSeek V3 作为一个通用 NLP 模型,适用于广泛的应用场景,能够高效处理各种文本生成、摘要和对话任务。

• DeepSeek R1 则专注于逻辑推理和问题求解,借助强化学习优化推理能力,适用于推理密集型任务。

现在 DeepSeek 的 Chat 应用,应该是结合了两个模型的优势。在对话框中如果开启了深度思考模式,就会启用 R1模型。想必其它 AI 厂商很快就会跟进,也会加入深度思考模式。

嘿,伙伴们,今天我们的AI探索之旅已经圆满结束。关于“deepseek 模型 V3 和 R1 的区别”的内容已经分享给大家了。感谢你们的陪伴,希望这次旅程让你对AI能够更了解、更喜欢。谨记,精准提问是解锁AI潜能的钥匙哦!如果有小伙伴想要了解学习更多的AI知识,请关注我们的官网“AI智研社”,保证让你收获满满呦!

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫

还没有评论呢,快来抢沙发~