Ai图生视频第三章之MOFA-Video让静态图片“活”起来: MOFA-Video 是一项基于生成运动场适应技术的图像动画工具,能够让静态图片“活”起来。通过轨迹、关键点或音频驱动,M……

哈喽!伙伴们,我是小智,你们的AI向导。欢迎来到每日的AI学习时间。今天,我们将一起深入AI的奇妙世界,探索“Ai图生视频第三章之MOFA-Video让静态图片“活”起来”,并学会本篇文章中所讲的全部知识点。还是那句话“不必远征未知,只需唤醒你的潜能!”跟着小智的步伐,我们终将学有所成,学以致用,并发现自身的更多可能性。话不多说,现在就让我们开始这场激发潜能的AI学习之旅吧。

Ai图生视频第三章之MOFA-Video让静态图片“活”起来:

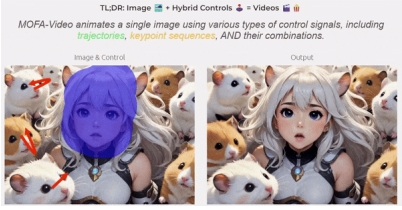

MOFA-Video 是一项基于生成运动场适应技术的图像动画工具,能够让静态图片“活”起来。通过轨迹、关键点或音频驱动,MOFA-Video 能够实现对静态图像的精准控制和动态化处理。本文将为您详细介绍 MOFA-Video 的功能特点、安装步骤以及如何快速上手使用。

一、前言介绍

1.1 MOFA-Video 是什么?

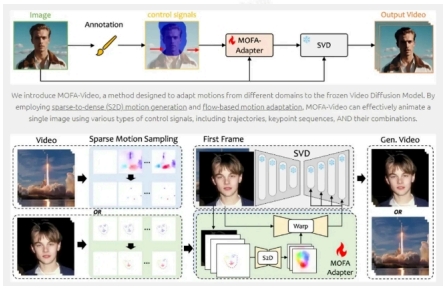

MOFA-Video 是一种可控的图像动画解决方案,基于冻结图像到视频扩散模型(Frozen Image-to-Video Diffusion Model)。它通过生成运动场适应技术(Generative Motion Field Adaptions),实现了对静态图像的动态化处理。无论是基于轨迹、关键点还是音频驱动,MOFA-Video 都能为用户提供灵活的控制选项。

1.2 运行环境介绍

– Python 3.10 及以上版本。

– PyTorch 2.0 及以上版本。

– 建议使用 CUDA 12.1 及以上版本(适用于 GPU 用户)。

1.3 MOFA-Video 技术亮点

1.生成运动场适应:通过生成运动场适应技术,实现对静态图像的精准控制。

2.多种驱动方式:支持轨迹、关键点、音频和参考视频等多种驱动方式。

3.零样本功能:无需额外训练即可实现混合控制、运动画笔等功能。

4.广泛适用性:适用于人脸动画、物体运动模拟等场景。

1.4 MOFA-Video 技术讲解

MOFA-Video 的核心在于其冻结图像到视频扩散模型。通过对输入图像进行运动场适应,结合用户指定的控制参数(如轨迹、关键点或音频),生成高质量的动态视频。

二、环境搭建

2.1 下载代码

首先,克隆 MOFA-Video 的代码仓库:

bash:

$ git clone https://github.com/MyNiuuu/MOFA-Video

$ cd MOFA-Video

2.2 构建环境

创建并激活一个新的 Python 环境:

bash:

$ conda create -n py310 python=3.10 #创建新环境

$ source activate py310 #激活环境

2.3 安装依赖

安装必要的依赖包:

bash:

$ pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple –ignore-installed

$ pip install opencv-python-headless

$ pip install “git+https://github.com/facebookresearch/pytorch3d.git”

2.4 下载模型

1. 下载 SVD_xt 的预训练模型,并存放到 ./ckpts 目录中:

bash:

下载地址:https://huggingface.co/stabilityai/stable-video-diffusion-img2vid-xt-1-1

2. 下载 MOFA-Adapter 的模型,并存放到 ./ckpts 目录中:

bash:

下载地址:https://huggingface.co/MyNiuuu/MOFA-Video-Traj

3. 下载 CMP 的模型,并存放到 ./models/cmp/experiments/semiauto_annot/resnet50_vip+mpii_liteflow/checkpoints 目录中:

bash:

下载地址:https://huggingface.co/MyNiuuu/MOFA-Video-Traj/blob/main/models/cmp/experiments/semiauto_annot/resnet50_vip%2Bmpii_liteflow/checkpoints/ckpt_iter_42000.pth.tar

三、Run Gradio Demo

3.1 Run Gradio Demo

运行以下命令启动 Gradio 演示界面:

bash:

$ python run_gradio.py

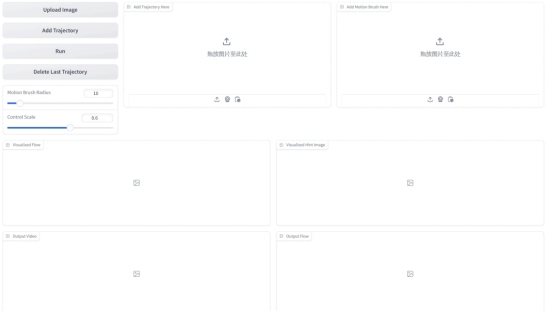

操作步骤:

1. 使用“Upload Image”按钮上传图片。

2. 单击“Add Trajectory”,在图像上选择点以绘制轨迹。

3. 调整控制比例(建议值为 0.6)。

4. 使用“Motion Brush Radius”调整运动画笔半径。

5. 单击“Run”按钮生成动画。

3.2 使用音频驱动

切换到 MOFA-Video-Hybrid 目录,运行以下命令:

bash:

$ cd ./MOFA-Video-Hybrid

$ python run_gradio_audio_driven.py

3.3 使用参考视频驱动

同样在 MOFA-Video-Hybrid 目录下,运行以下命令:

bash:

$ python run_gradio_video_driven.py

四、具体效果演示

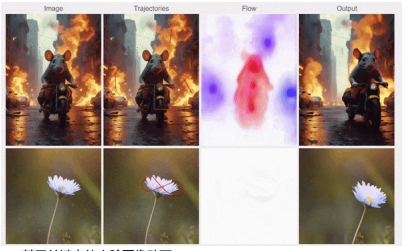

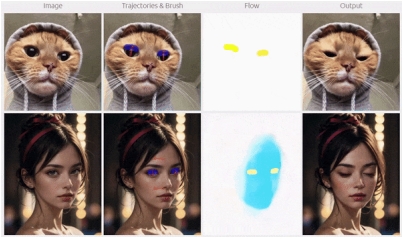

4.1 基于轨迹的图像动画

通过绘制轨迹控制图像的动态效果,例如物体的移动路径或旋转方向。

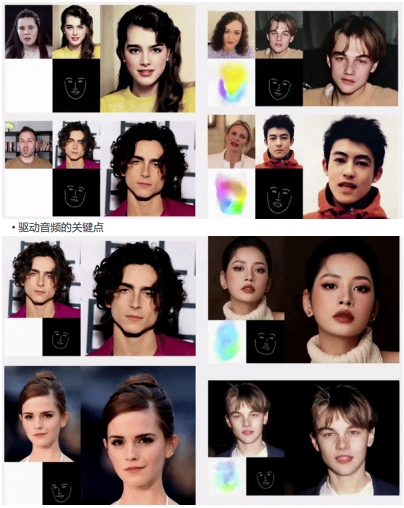

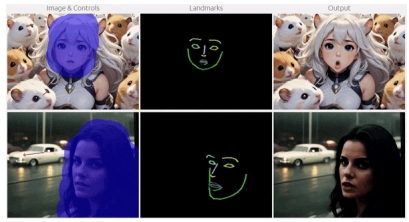

4.2 基于关键点的人脸图像动画

支持通过驱动视频或音频的关键点,生成逼真的人脸动画。

4.3 零样本功能

-混合控制:结合多种控制方式生成复杂动画。

希望这篇教程能帮助您快速上手 MOFA-Video!如果您有任何疑问或需要进一步的帮助。

嘿,伙伴们,今天我们的AI探索之旅已经圆满结束。关于“Ai图生视频第三章之MOFA-Video让静态图片“活”起来”的内容已经分享给大家了。感谢你们的陪伴,希望这次旅程让你对AI能够更了解、更喜欢。谨记,精准提问是解锁AI潜能的钥匙哦!如果有小伙伴想要了解学习更多的AI知识,请关注我们的官网“AI智研社”,保证让你收获满满呦!

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫

还没有评论呢,快来抢沙发~