Transformer面试题总结86-90: 《Transformer面试题总结》系列教程专为求职者打造,深入解析Transformer的核心原理、架构细节及实际应用。教程涵盖自注意力机制、编码器……

哈喽!伙伴们,我是小智,你们的AI向导。欢迎来到每日的AI学习时间。今天,我们将一起深入AI的奇妙世界,探索“Transformer面试题总结86-90”,并学会本篇文章中所讲的全部知识点。还是那句话“不必远征未知,只需唤醒你的潜能!”跟着小智的步伐,我们终将学有所成,学以致用,并发现自身的更多可能性。话不多说,现在就让我们开始这场激发潜能的AI学习之旅吧。

Transformer面试题总结86-90:

《Transformer面试题总结》系列教程专为求职者打造,深入解析Transformer的核心原理、架构细节及实际应用。教程涵盖自注意力机制、编码器-解码器结构、位置编码等高频考点,结合经典面试题,提供清晰易懂的解析与实战技巧。无论你是入门小白还是技术达人,都能快速掌握Transformer的核心知识,轻松应对面试挑战,提升求职成功率!

86.请详解描述使用Transformer 进行Transfer Learning 中具体Prior 和Posterior Probability地方及其具体的功能和数学原理

答案:

参数初始化:在迁移学习中,可以使用先验概率来初始化Transformer模型的参数。先验概率可以基于已有的大规模数据集进行估计,例如在自然语言处理任务中,可以使用大规模的文本语料库。通过使用先验概率初始化模型参数,可以更好地利用先前任务学到的知识,并帮助模型更快地收敛到新任务上。

Fine-tuning:在迁移学习中,Fine-tuning是一种常见的策略,其中已经在一个任务上训练好的模型在新任务上进行微调。在Fine-tuning过程中,可以使用后验概率来调整模型参数,以更好地适应新任务的特征和数据分布。后验概率可以基于新任务的训练数据进行估计,并用于更新模型参数。通过这种方式,模型可以在新任务上进行更精细的调整,以提高性能。

领域适应:在迁移学习中,常常会遇到源域(source domain)和目标域(target domain)之间的领域差异。在这种情况下,可以使用先验概率和后验概率来进行领域适应。先验概率可以基于源域数据进行估计,用于初始化模型参数,而后验概率可以基于目标域数据进行估计,用于微调模型参数以适应目标域数据的特征。

87.请描述Transformer 在Training 和Inference 对MLE(maximum likelihood estimation)模型具体应用

答案:

在Transformer模型的训练和推断过程中,通常使用MLE(最大似然估计)作为模型参数的优化目标。

下面分别描述了在训练和推断阶段如何应用MLE:

在训练阶段:

目标函数(损失函数):在训练阶段,Transformer模型通过最小化负对数似然损失(Negative Log-Likelihood Loss)来优化模型参数。这个损失函数衡量了模型在给定输入序列条件下,预测输出序列的概率与真实输出序列的差异。

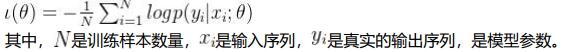

数学公式:

参数优化:使用梯度下降等优化算法,通过最小化负对数似然损失来更新模型参数,使得模型的输出概率分布更接近于真实的输出分布。

在推断阶段:

在推断阶段,Transformer模型通常使用贪婪解码或集束搜索等方法来生成输出序列。这些方法并不直接使用MLE,但仍然依赖于模型训练过程中学到的参数。

贪婪解码(Greedy Decoding):在贪婪解码中,每次预测时选择当前最可能的词作为输出,并将其作为下一步的输入,直到生成整个输出序列。虽然贪婪解码并不保证全局最优解,但它是一种简单高效的解码方法。

集束搜索(Beam Search):在集束搜索中,模型生成多个假设的输出序列,并根据预测概率来选择最有可能的序列。集束搜索可以看作是一种近似的MLE推断方法,它在推断阶段尽可能地选择概率较大的序列。

在训练和推断阶段,MLE模型可以通过最大化训练数据的似然来学习数据分布的参数,并在推断阶段生成符合数据分布的输出序列。这样的模型在实际应用中通常具有良好的性能和泛化能力。

88.请描述Transformer 在Training 的时候具体使用MAP(Maximum A Posteriori) estimation模型的地方并描述其流程机制和数学原理

答案:

具体地说,可以将模型参数的先验分布引入到训练过程中,通过最大化后验概率来优化模型参数。在Transformer中,可以使用MAP估计来获得更鲁棒的模型,尤其是在训练数据较少或噪声较多的情况下。

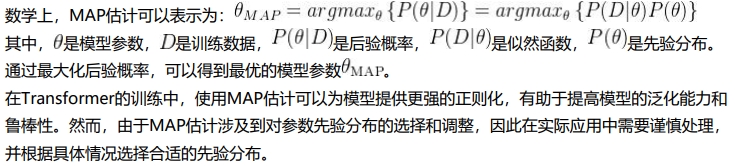

下面是使用MAP估计进行Transformer训练的一般流程和数学原理:

流程:

定义先验分布:首先,需要定义模型参数的先验分布。先验分布可以是任何合适的分布,通常选择高斯分布或者拉普拉斯分布等。这个先验分布可以基于领域知识或者经验选择。

定义似然函数:然后,定义似然函数,用于衡量模型在给定训练数据下的可能性。在Transformer中,似然函数通常采用负对数似然损失函数,用于衡量模型在给定输入序列条件下,预测输出序列的概率与真实输出序列的差异。

最大化后验概率:最终目标是最大化后验概率,即给定观测数据,找到最可能的模型参数。根据贝叶斯定理,后验概率可以表示为似然函数与先验分布的乘积。使用MAP估计,可以通过最大化后验概率来更新模型参数。

89.请描述Transformer 在训练的过程中什么情况下使用MLE 和MAP 是基本没有区别的,其背后的数学原理是什么?

答案:

在Transformer的训练过程中,当模型参数的先验分布对训练数据的影响非常小或者可以忽略不计时,MLE(Maximum Likelihood Estimation)和MAP(Maximum A Posteriori)估计之间可能基本没有区别。这通常发生在以下情况下:

均匀先验分布:如果模型参数的先验分布是均匀分布或者是一个非常宽松的先验分布,那么在最大化后验概率时,先验分布对最终的参数估计影响非常小。这时,MAP估计会退化为MLE估计。

大量训练数据:当有大量的训练数据可用时,数据中包含的信息足以弥补先验分布的不确定性。在这种情况下,数据的影响可能会比先验分布的影响更大,使得MAP估计和MLE估计产生的参数基本一致。

90.为什么一般情况下Transformer 的训练不会完全使用Bayesian 模型而是更倾向于采用NaiveBayes?请具体阐述其架构和背后的数学原理

答案:

一般情况下,Transformer的训练不会完全使用贝叶斯模型,而更倾向于采用Naive Bayes的主要原因是贝叶斯方法在实际应用中往往面临计算复杂度高的挑战,尤其是对于复杂的深度学习模型。以下是关于为何Transformer更倾向于采用Naive Bayes的解释:

1. 计算复杂度:

贝叶斯方法在模型训练和推断过程中需要进行全局概率推断,涉及对所有参数的联合概率分布进行计算,这导致了计算复杂度较高。而Transformer模型通常具有大量参数,包括许多可训练的注意力权重矩阵和前馈网络参数,使得完全使用贝叶斯方法的计算成本非常高昂,不太实际。

2. 近似推断:

在实践中,为了降低计算复杂度,通常需要使用近似推断方法来近似后验概率分布。然而,这些近似推断方法可能会引入误差,影响模型的性能和鲁棒性。相比之下,Naive Bayes模型通常具有更简单的参数结构,可以更容易地进行近似推断,且不会受到高维参数空间的困扰。

3. 模型设计和架构:

Transformer模型的设计主要侧重于使用自注意力机制来捕捉输入序列中的长程依赖关系,以及通过多层前馈网络来提取特征。这种设计更适合于端到端的深度学习训练框架,而不是传统的贝叶斯建模框架。相比之下,Naive Bayes模型具有简单的参数结构,易于训练和解释,更适合于传统的贝叶斯建模框架。数学原理:

Naive Bayes模型基于贝叶斯定理,假设输入特征之间相互独立,这样可以将联合概率分布拆解为各个特征的条件概率的乘积。这种假设简化了模型的参数估计和推断过程,降低了计算复杂度,但可能会引入特征之间的误差。相比之下,完全贝叶斯方法需要对所有参数的联合概率分布进行计算,计算复杂度较高,不太适用于大规模深度学习模型。

嘿,伙伴们,今天我们的AI探索之旅已经圆满结束。关于“Transformer面试题总结86-90”的内容已经分享给大家了。感谢你们的陪伴,希望这次旅程让你对AI能够更了解、更喜欢。谨记,精准提问是解锁AI潜能的钥匙哦!如果有小伙伴想要了解学习更多的AI知识,请关注我们的官网“AI智研社”,保证让你收获满满呦!

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫

还没有评论呢,快来抢沙发~