Transformer面试题总结66-70: 《Transformer面试题总结》系列教程专为求职者打造,深入解析Transformer的核心原理、架构细节及实际应用。教程涵盖自注意力机制、编码器……

哈喽!伙伴们,我是小智,你们的AI向导。欢迎来到每日的AI学习时间。今天,我们将一起深入AI的奇妙世界,探索“Transformer面试题总结66-70”,并学会本篇文章中所讲的全部知识点。还是那句话“不必远征未知,只需唤醒你的潜能!”跟着小智的步伐,我们终将学有所成,学以致用,并发现自身的更多可能性。话不多说,现在就让我们开始这场激发潜能的AI学习之旅吧。

Transformer面试题总结66-70:

《Transformer面试题总结》系列教程专为求职者打造,深入解析Transformer的核心原理、架构细节及实际应用。教程涵盖自注意力机制、编码器-解码器结构、位置编码等高频考点,结合经典面试题,提供清晰易懂的解析与实战技巧。无论你是入门小白还是技术达人,都能快速掌握Transformer的核心知识,轻松应对面试挑战,提升求职成功率!

66.请描述Beam Search 算法在Transformer 中的具体应用并阐述其有效性的数学数学假设和数学公式

答案:

Beam Search算法是一种用于生成序列的搜索算法,常用于生成式模型中,例如在Transformer中用于解码器生成文本的过程中。其核心思想是在每个时间步选择最有可能的几个候选词,然后在下一个时间步继续考虑这些候选词,直到生成完整的序列为止。

在Transformer中,Beam Search算法通常用于解码器生成文本的过程中,具体应用如下:

初始阶段:在初始阶段,解码器接收到一个特殊的起始标记作为输入,然后计算初始的概率分布。

候选词选择:根据当前时间步的概率分布,选择最有可能的K个候选词作为下一个时间步的输入。这些候选词通常是通过对概率分布进行排序或采样得到的。

生成序列:在每个时间步重复上述过程,直到生成的序列达到预定的长度或遇到终止标记为止。

Beam Search算法的有效性基于以下数学假设和原理:

局部最优性:Beam Search算法假设在每个时间步选择概率最高的K个候选词能够得到全局最优解。这个假设的数学原理是基于贪心法,认为每个时间步的最优选择会导致整体序列的最优解。

剪枝策略:为了减少搜索空间和提高效率,Beam Search算法使用剪枝策略,即在每个时间步只保留概率最高的K个候选词,而抛弃其他不太可能的选择。这个策略的数学原理是基于动态规划,通过不断更新局部最优解来逐步求解全局最优解。

Beam Search算法的数学公式可以表示为:

其中,s是输入序列,y是生成的序列,p(y_t|y

Encoding?

Encoder:在Transformer的编码器中,可以将知识图谱中的边作为输入序列,利用位置编码将边的顺序信息和Transformer模型的位置信息结合起来。Encoder会将每个边的信息编码成固定维度的向量表示,这些向量表示可以捕获边的语义信息和关系。边的编码可以考虑边的类型、起点和终点实体的信息,以及边的属性等。

Decoder:Decoder可以根据编码后的边的向量表示,生成新的边或对知识图谱中的边进行推断。例如,在知识图谱补全任务中,Decoder可以接收已知实体的向量表示作为输入,并预测与这些实体相关的新边。Decoder也可以用于知识图谱推理任务,根据已有的边推断出新的边或实体之间的关系。

关于如何在Transformer中有效地对知识图谱中的边进行编码,可以考虑以下几点:

注意力机制:使用注意力机制可以让模型在编码边的时候更加关注与当前边相关的实体和属性信息,从而提高编码的效率和质量。

多层特征抽取:可以设计多层的Transformer编码器来提取边的多层次特征表示,以捕获不同层次的语义信息。

预训练和微调:可以使用预训练的Transformer模型来学习通用的边的表示,然后在特定任务上进行微调,以提高模型在知识图谱任务上的性能。

68.如何由你使用Transformer 来实现一个对话系统,如何判定用户当前的交流的内容是否离题,例如在办理一项业务过程中突然对话机器人今天天气怎么?请阐述架构思路及数学原理

答案:

Encoder-Decoder架构:使用Transformer模型的Encoder-Decoder架构来构建对话系统。Encoder负责将用户输入的对话内容编码成向量表示,Decoder则负责根据编码后的表示生成回复。

上下文处理:在对话系统中,需要考虑上下文信息,即前文对话内容对当前对话的影响。可以使用带有位置编码的Transformer来处理连续对话中的上下文信息,确保模型能够理解和生成连贯的对话。

注意力机制:使用注意力机制来捕获对话中的重要信息,使得模型能够在生成回复时更关注与当前上下文相关的内容。通过注意力机制,模型可以自动学习到哪些部分的输入对于生成正确回复更为重要。

离题检测:在对话系统中,用户可能会偏离主题提出无关话题。为了判定用户当前的交流内容是否离题,可以采用监督学习或无监督学习的方法,使用分类模型或聚类模型来识别离题对话。这些模型可以基于历史对话数据训练,学习识别离题对话的模式。

数学原理:在Transformer模型中,数学原理主要包括自注意力机制、多头注意力机制和前馈神经网络等。自注意力机制用于计算输入序列中每个位置的注意力权重,多头注意力机制能够捕获不同类型的注意力信息,前馈神经网络用于在每个位置上对注意力信息进行非线性变换。

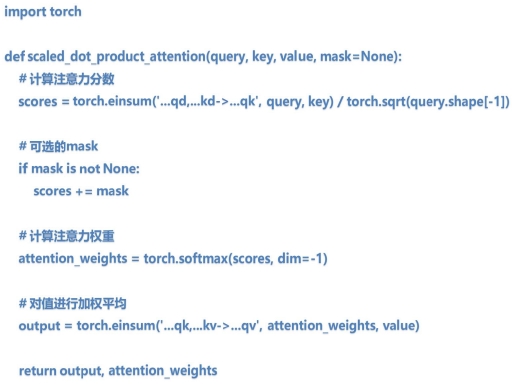

69.请使用Einsum 的方式编码实现Transformer 的Attention 机制

答案:

70.请描述Transformer 使用动态Batch Size 进行训练的原理、流程和数学证明

Transformer 使用动态Batch Size 进行训练时,通常是指在每个训练步骤中,批次(Batch)的大小可以变化。这种方法可以带来一些优势,比如更高效地利用计算资源、更好地处理不同长度的序列等。

原理:动态Batch Size 的训练原理基于对训练样本的灵活处理,即在每个训练步骤中根据需要调整批次的大小。这种灵活性使得模型能够适应不同大小的数据集,并且在训练过程中可以更好地处理不同长度的序列,提高训练的效率和性能。

流程:动态Batch Size 的训练流程与传统的批次训练流程类似,但在每个训练步骤中需要动态调整批次的大小。

具体流程如下:

从数据集中随机抽取一批训练样本。

根据需要调整批次中样本的大小,比如根据样本的长度进行排序,并将相似长度的样本组成一个批次。

将调整后的批次输入到模型中进行前向传播和反向传播。

根据损失函数更新模型参数。

重复以上步骤直至完成一个训练周期(epoch)。

数学证明:动态Batch Size 的训练原理并不涉及特定的数学证明,而是基于对训练数据的动态处理和调整。其有效性可以通过实验证明,比如与固定Batch Size 训练相比,动态Batch Size 可能会带来更好的训练效果、更高的模型性能等。通过实验验证,可以证明动态Batch Size 训练的有效性和性能提升。

嘿,伙伴们,今天我们的AI探索之旅已经圆满结束。关于“Transformer面试题总结66-70”的内容已经分享给大家了。感谢你们的陪伴,希望这次旅程让你对AI能够更了解、更喜欢。谨记,精准提问是解锁AI潜能的钥匙哦!如果有小伙伴想要了解学习更多的AI知识,请关注我们的官网“AI智研社”,保证让你收获满满呦!

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫

还没有评论呢,快来抢沙发~