大模型LLM面试题大全超详细解析11-15题: 《大模型LLM面试题大全超详细解析》系列教程旨在帮助求职者系统掌握大模型相关面试知识。教程涵盖模型原理、训练技巧、应用场……

哈喽!伙伴们,我是小智,你们的AI向导。欢迎来到每日的AI学习时间。今天,我们将一起深入AI的奇妙世界,探索“大模型LLM面试题大全超详细解析11-15题”,并学会本篇文章中所讲的全部知识点。还是那句话“不必远征未知,只需唤醒你的潜能!”跟着小智的步伐,我们终将学有所成,学以致用,并发现自身的更多可能性。话不多说,现在就让我们开始这场激发潜能的AI学习之旅吧。

大模型LLM面试题大全超详细解析11-15题:

《大模型LLM面试题大全超详细解析》系列教程旨在帮助求职者系统掌握大模型相关面试知识。教程涵盖模型原理、训练技巧、应用场景及优化策略等核心内容,结合真实面试题,提供详细解析与实战技巧。无论你是初学者还是进阶者,都能从中获得实用指导,轻松应对大模型领域的面试挑战,提升求职竞争力。

11. 模型部署与维护

答案:

大型语言模型的部署和维护涉及多个技术和操作挑战,包括模型的持续优化、性能监控和更新。

应对策略:

持续集成和持续部署(CI/CD):建立自动化流程,以便模型更新可以迅速且频繁地部署,同时保持高质量标准。

性能监控:实施实时监控系统来跟踪模型性能和用户反馈,及时发现和修正问题。

版本控制:使用版本控制系统管理模型的不同版本,确保可回溯和可管理。

灾难恢复计划:制定灾难恢复计划和备份策略,以防止数据丢失或系统故障。

12. 未来展望与创新

答案:

未来几年内,大型语言模型(LLM)技术可能的发展方向包括:更高效的模型和算法:研究更高效的训练算法和模型架构,以降低计算成本和提高模型性能。

更强的跨任务和跨领域适应能力:开发能够在更广泛任务和领域中表现出色的通用模型。

增强的可解释性和透明度:进一步提高模型的可解释性,使非专业用户也能理解模型决策。

更严格的伦理和隐私保护措施:随着对AI伦理和隐私保护意识的提高,未来的模型将更加注重这些方面的设计。

13. 主流结构

答案:

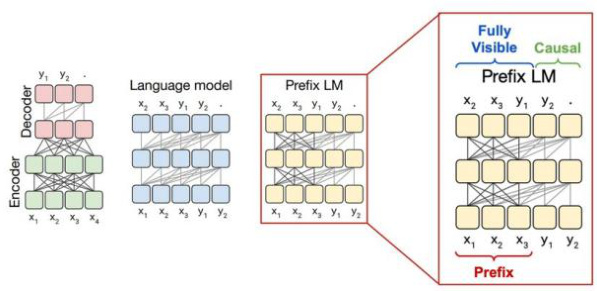

目前LLM(Large Language Model)主流结构包括三种范式,分别为Encoder-Decoder、CausalDecoder、Prefix Decoder,如下图所示:

结构特点:输入双向注意力,输出单向注意力代表模型:T5、Flan-T5、BART

Causal Decoder 结构特点:从左到右的单向注意力代表模型:LLaMA1/2系列、LLaMA衍生物

Prefix Decoder 结构特点:输入双向注意力,输出单向注意力代表模型:ChatGLM、ChatGLM2、U-PaLM

14. 结构对比

答案:

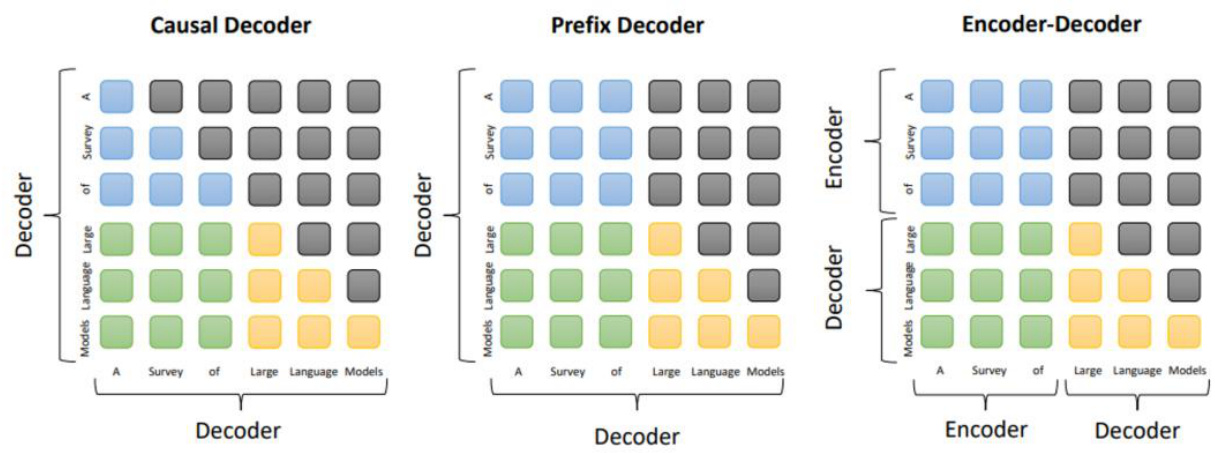

三种结构主要区别在于Attention Mask不同,如下图所示:

Encoder-Decoder 特点:在输入上采用双向注意力,对问题的编码理解更充分;缺点:在长文本生成任务上效果差,训练效率低;适用任务:在偏理解的NLP 任务上效果好。

Causal Decoder

特点:自回归语言模型,预训练和下游应用是完全一致的,严格遵守只有后面的token才能看到前面的token的规则;

优点:训练效率高,zero-shot 能力更强,具有涌现能力;

适用任务:文本生成任务效果好

Prefix Decoder

特点:Prefix部分的token互相能看到,属于Causal Decoder 和Encoder-Decoder 的折中;

缺点:训练效率低。

15. 训练目标

答案:

语言模型

训练效率:Prefix Decoder < Causal Decoder

Causal Decoder 结构会在所有token上计算损失,而Prefix Decoder只会在输出上计算损失。

去噪自编码器

随机替换掉一些文本段,训练语言模型去恢复被打乱的文本段,即完形填空,训练目标函数为:去噪自编码器的实现难度更高,采用去噪自编码器作为训练目标的任务有GLM-130B、T5等。根据OpenAI 联合创始人Andrej Karpathy 在微软Build 2023 大会上所公开的信息,OpenAI 所使用的大规模语言模型构建流程如下图1所示。主要包含四个阶段:预训练、有监督微调、奖励建模、强化学习。这四个阶段都需要不同规模数据集合以及不同类型的算法,会产出不同类型的模型,同时所需要的资源也有非常大的差别。

嘿,伙伴们,今天我们的AI探索之旅已经圆满结束。关于“大模型LLM面试题大全超详细解析11-15题”的内容已经分享给大家了。感谢你们的陪伴,希望这次旅程让你对AI能够更了解、更喜欢。谨记,精准提问是解锁AI潜能的钥匙哦!如果有小伙伴想要了解学习更多的AI知识,请关注我们的官网“AI智研社”,保证让你收获满满呦!

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫

还没有评论呢,快来抢沙发~