首篇Test-Time Scaling系统综述:原理与实现四维拆解: 当训练成本飙升、数据枯竭,如何继续激发大模型潜能? 随着大模型训练成本急剧攀升、优质数据逐渐枯竭,推理阶段……

哈喽!伙伴们,我是小智,你们的AI向导。欢迎来到每日的AI学习时间。今天,我们将一起深入AI的奇妙世界,探索“首篇Test-Time Scaling系统综述:原理与实现四维拆解”,并学会本篇文章中所讲的全部知识点。还是那句话“不必远征未知,只需唤醒你的潜能!”跟着小智的步伐,我们终将学有所成,学以致用,并发现自身的更多可能性。话不多说,现在就让我们开始这场激发潜能的AI学习之旅吧。

首篇Test-Time Scaling系统综述:原理与实现四维拆解:

当训练成本飙升、数据枯竭,如何继续激发大模型潜能?

随着大模型训练成本急剧攀升、优质数据逐渐枯竭,推理阶段扩展(Test-Time Scaling, TTS) 迅速成为后预训练时代的关键突破口。与传统的“堆数据、堆参数”不同,TTS 通过在推理阶段动态分配算力,使同一模型变得更高效、更智能——这一技术路径在 OpenAI-o1 和 DeepSeek-R1 的实践中已初显威力。

在数学、编程等硬核任务上,TTS 表现亮眼;而在开放问答、多模态理解乃至复杂规划等场景中,它同样展现出巨大潜力。目前,研究者已探索了多种 TTS 策略,如 Chain-of-Thought (CoT)、Self-Consistency、Search 和 Verification,但该领域仍缺乏统一的研究视角与评估框架。

最近,来自香港城市大学、McGill、人大高瓴、香港中文大学、Salesforce 等机构的研究者联合发布了首篇系统性的 Test-Time Scaling 领域综述:

《What, How, Where, and How Well? A Survey on Test-Time Scaling in Large Language Models》

论文链接:https://arxiv.org/pdf/2503.24235

论文亮点概览:

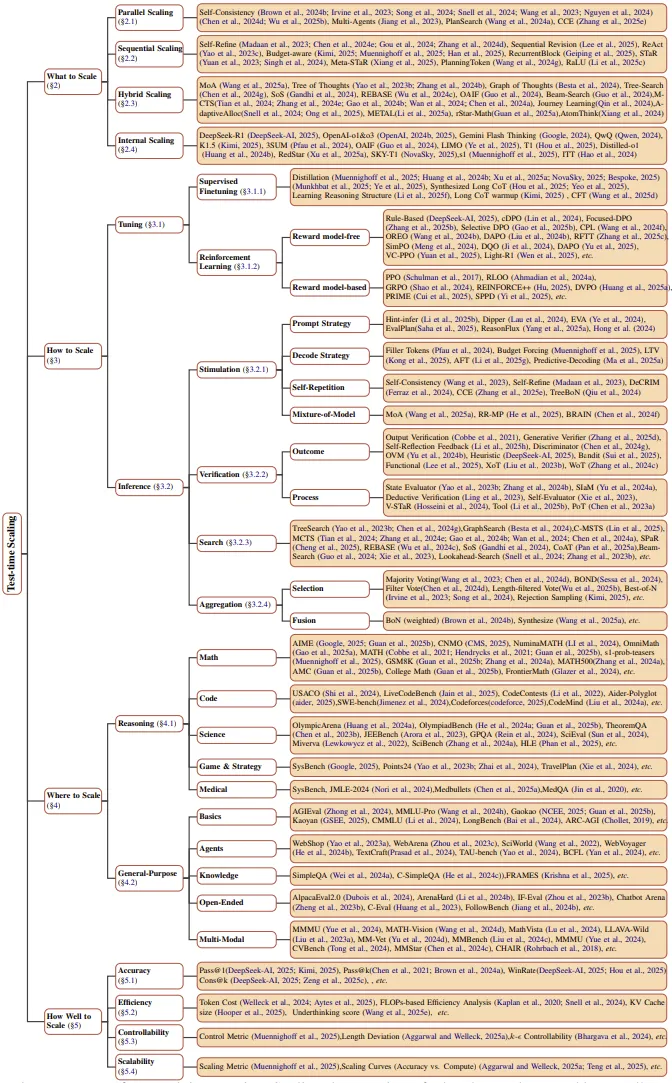

本篇Survey首次提出了一个覆盖全面、多层次、可扩展的四维正交分析框架

1.What to scale:扩什么?CoT长度、样本数、路径深度还是内在状态?

2.How to scale:怎么扩?Prompt、Search、RL,还是Mixture-of-Models?

3.Where to scale:在哪扩?数学、代码、开放问答、多模态……

4.How well to scale:扩得怎样?准确率、效率、控制性、可扩展性……

在这个框架下,作者系统梳理了当前的主流TTS技术路线,包括:

• 并行策略(Self-Consistency / Best-of-N)

• 逐步演化(STaR / Self-Refine)

• 搜索推理(Tree-of-Thought / MCTS)

• 内在优化(DeepSeek-R1 / OpenAI-o1)

基于这一框架,作者系统性地梳理了现有文献,实现了三大核心贡献:

1.文献解析:通过结构化分析方法,清晰界定各项研究的创新边界与价值定位;

2.路径提炼:总结出推理阶段扩展技术的三大发展方向:计算资源动态优化、推理过程增强和多模态任务适配;

3.实践指导:针对数学推理、开放问答等典型场景,提供具体可操作的技术选型建议。

与同类综述相比,本文特别注重实用价值,不仅系统评估了不同TTS策略的性价比,还前瞻性地探讨了该技术的未来演进方向,包括轻量化部署、持续学习融合等潜在突破点。

1.研究背景

2024年上半年,已有研究者指出:尽管Scaling Law依然有效,但面对人类可用数据枯竭和模型参数消耗严重的问题,其发展速度将被迫减缓。这一判断后来得到了OpenAI前首席科学家 Ilya Sutskever 的印证——他在NeurIPS 2024演讲中明确提出”pretraining as we know it will end”。在此背景下,当模型已掌握人类世界的全部知识后,如何更充分地激发其解决问题的能力,便成为后续研究的核心议题。

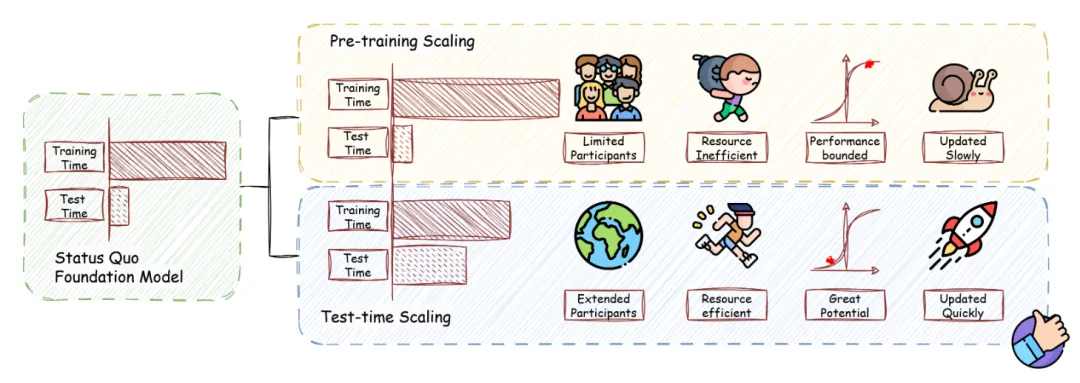

人类认知机制为我们提供了重要启示:面对复杂问题时,深度思考与系统规划往往能带来更优的解决方案。受此启发,研究者提出在模型推理阶段动态分配额外计算资源以提升性能。有趣的是,多项实验观测到了类似于“扩展法则”的趋势:推理阶段增加计算开销会带来持续的性能提升。这一现象催生了推理阶段扩展(Test-Time Scaling, TTS)技术,其核心是通过渐进式计算资源分配来激发模型的潜在智能。

近期,o1和R1等先进推理模型的卓越表现,不仅验证了TTS技术的有效性,更推动其成为增强大语言模型(LLM)推理能力的关键范式。研究表明,TTS在保持模型参数和与训练成本不变的前提下,能显著提升复杂任务的解决能力,展现出广阔的应用前景。

图1:预训练扩展和推理阶段扩展的示意。

尽管TTS研究呈现爆发式增长,该领域仍面临三大关键挑战:

1)方法论碎片化:缺乏统一框架整合现有成果;

2)评估标准缺失:难以客观比较不同方法的优劣;

3)发展规律模糊:尚未识别出技术演进的内在一致性。

为填补这一空白,本文提出了一项关于 TTS 的全面综述,构建了一个分层且可扩展的分析框架,以系统化地梳理现有方法、整理研究进展,并为未来发展提供指导。

2.框架介绍

作者提出的框架从四个正交维度系统解构TTS技术:

1、What to Scale(扩展什么)- 界定推理过程中需要扩展的具体对象,包括:

• Parallel Scaling(并行扩展):并行生成多个输出,然后将其汇总为最终答案,从而提高测试时间性能;

• Sequential Scaling(序列扩展):根据中间步骤明确指导后面的计算;

• Hybrid Scaling(混合扩展):利用了并行和顺序扩展的互补优势;

• Internal Scaling(内生扩展):在模型内部参数范围内自主决定分配多少计算量进行推理,而非外部人类指导策略。

其中,作者为每一个扩展的形式,都进行了一些经典工作的介绍,从而丰富了对于扩展策略的外延描述,例如:在并行扩展中作者根据得到覆盖性的来源分为两个更小的类别,在单个模型上的反复采样和多个模型的采样。

2、How to Scale(怎么扩展)- 归纳实现扩展的核心技术路径:

• 训练阶段方法:监督微调(SFT)、强化学习(RL)等

• 推理阶段技术:刺激策略(Stimulation)、验证技术(Verification)、搜索方法(Search)、集成技术(Aggregation)

这个章节是重点章节,作者收录并整理了大量的经典的和最前沿的技术,例如在训练阶段中的强化学习技术,伴随R1而大火,因此在短短两个月内涌现出大量的工作,作者将它们尽数收入,同时分成基于奖励模型和不需奖励模型两类;对于刺激策略,作者分成了提示(Prompt),解码(Decode)、自重复(Self-Repetition)、模型混合(mixture-of-model)四类。

3、Where to Scale(在哪里扩展)- 明确技术适用的任务场景与数据集特性。

作者在这里提出尽管TTS的推出和验证是在某一类特定的推理任务上得到成功的,可是已经有足够多的工作开始显现出TTS是一种通用地能够提升在多样任务的策略,由此作者以推理(Reasoning)和通用 (General Purpose) 两类进行分类,一方面强调了TTS在越来越多样、越来越先进的推理任务中有很明显的效果,另一方面也不断跟踪TTS在更多通用任务上应用的效果。值得注意的是,作者整理出一个评测基准的表格,方便更多研究者直接从中去选择合适自己的基准。

4、How Well to Scale(效果怎么样)- 建立多维评估体系:

在当下,TTS已经不仅是一个提高任务准确率的策略,当它成为一个新的值得被研究的核心策略时,对TTS的要求会更加多元化,这也是未来研究的主题。作者认为之后对TTS的优化重点将不仅仅局限在准确率的提升,是在于如何提高效率、增强鲁棒性和消除偏见等。

图2:作者提出的TTS框架,包括what, how, where 和 how well to scale。

作者不仅在每个维度下提供细粒度子类划分,还配套标注了代表性研究工作(如图1所示),使分类体系兼具理论完备性和实践指导价值。这一结构化的基础使得后续研究可以无缝地融入作者的分类体系,更清晰地展现其贡献。

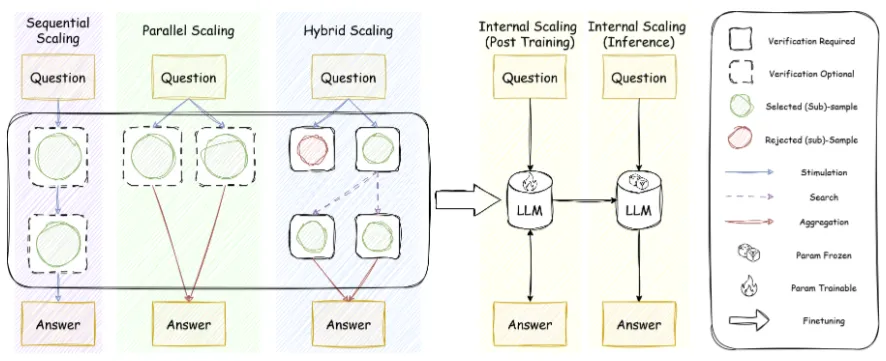

为了更好的理解what to scale中的并行扩展,序列扩展,结合扩展和内生扩展,作者用一张清晰的示意图进行形象化的展示,同时,在图中使用how to scale的技术来组成不同的扩展策略,很好地示意了两个维度如何结合在一起。

图3:从what to scale 到 how to scale。

3.实践特色

作者强调本篇 Survey 以实用为原则,具体包括:使用所提出的框架分析文献,以及整理操作指南。

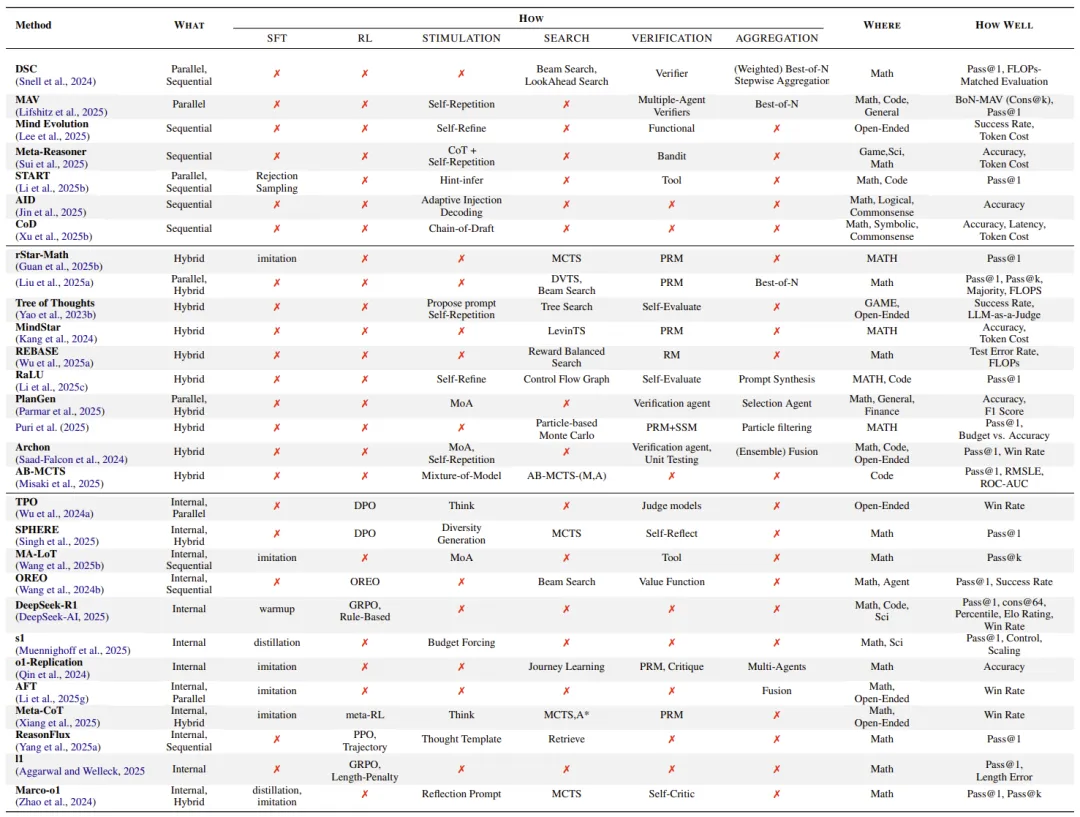

文献解析:为了帮助研究者系统性地剖析每项工作,作者设计了一个分析表格,通过将文献贡献对应到框架的四个维度(What/How/Where/How Well),以清晰地解构该工作。这种结构化分析方法不仅能清晰展现各研究的核心创新,更能有效揭示潜在的技术突破方向。

表1:在现有文献中进行推理扩展时常用的组合方式。

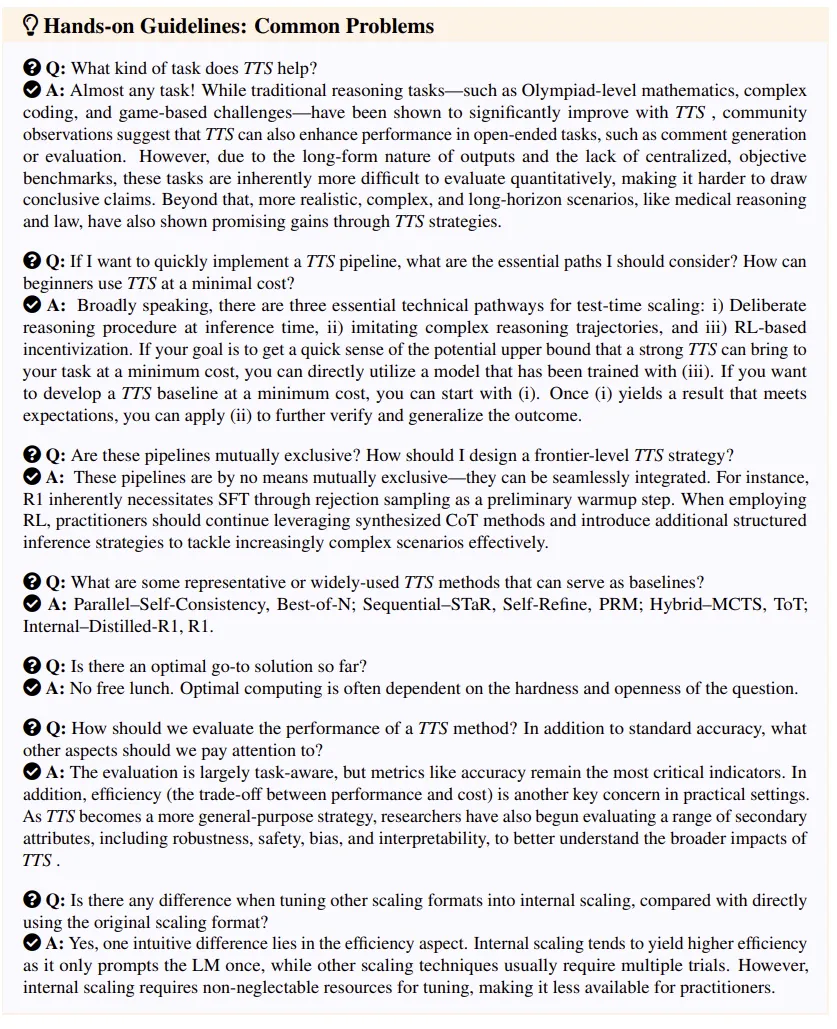

操作指南:另一个潜在的亮点是持续收集 TTS 开发中的实用操作指南,而这些操作指南将以问答的形式展现。作者期待这些问答是具体的、现实的、一线的,因此,作者期待这篇Survey将维持开放性,邀请更多在一线研究的学者来参与这项操作指南的收录和编写。下面是作者现阶段的操作指南的内容和风格。

4.挑战与未来

本文总结了 TTS 当前面临的四大挑战:

1.并行扩展的智能性不足:如何避免重复、低效的采样,真正覆盖多样的解空间?

2.逐步推理中的误差积累:能否构建“边推理边验证”的机制,减少中间错误的放大?

3.混合策略仍待统一框架:多模型、多策略如何协同运作,适应复杂现实任务?

4.内生推理尚缺可控性:推理路径隐式展开,难以追踪与调节资源消耗。

论文还指出,目前常见的技术如 SFT、RL、Reward Modeling 等虽被频繁使用,但背后的作用贡献尚不清晰,值得深入探索,例如:SFT真的不如RL更泛化吗?R1的时代下SFT的角色是什么?什么样的Reward Modeling更加高效?等等

此外未来TTS的发展重点包括:

1. 统一评估指标(准确率 vs 计算开销);

2. 拓展到金融、医学等真实场景;

3. 构建具备自适应推理能力的通用智能体。

推理扩展策略正引领 AI 推理范式转变:让模型在“用”的时候持续变强。

作者也欢迎更多在推理扩展研究一线的学者加入这项工作的共建,一起推动 TTS 成为推动 AGI 的关键基建!他们会在贡献小节和作者列表中增加提供深刻见解的学者。作者期待这个Survey可以成为推理扩展研究的小型社区,让这里充满开放的见解。

嘿,伙伴们,今天我们的AI探索之旅已经圆满结束。关于“首篇Test-Time Scaling系统综述:原理与实现四维拆解”的内容已经分享给大家了。感谢你们的陪伴,希望这次旅程让你对AI能够更了解、更喜欢。谨记,精准提问是解锁AI潜能的钥匙哦!如果有小伙伴想要了解学习更多的AI知识,请关注我们的官网“AI智研社”,保证让你收获满满呦!

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫

还没有评论呢,快来抢沙发~